BRICS: в поиске объективного рейтинга вузов

Рейтинги университетов подобны футболу: все знают, про что ЭТО, все досконально понимают, как ЭТО устроено, и все с огромным любопытством наблюдают за ЭТИМ. Под «этим» понимаются таблицы рейтингов, результат оценки деятельности университетов. «Всеми» являются участники масштабного сообщества под названием «высшее образование», объединяющего преподавателей, исследователей, администраторов, студентов, их родителей, чиновников. Простота представления социально значимой информации, интересующей миллионы, – вот залог успеха рейтингов вузов.

Наглядность и массовость также обеспечивают этому продукту полную интеграцию с системой массового потребления. Но можно ли оценить всю полноту деятельности организации в системе высшего образования через одно-единственное значение (абсолютное или процентное – неважно), через одну итоговую цифру, закрепляющую позицию того или иного вуза в пространстве рейтинговой таблицы? Хочется ответить: едва ли. Однако правильнее ответить: для массового потребителя всё возможно. И в этом ответе заключена абсолютная правота и логика рейтингов: рейтинг университетов (в смысле итогового представления результатов) — это не оценка университетов, не инструмент для анализа системы высшего образования, это в чистом виде масс-медийный продукт, инструмент маркетинга, рекламы, продвижения вуза на рынке образовательных и научных услуг. Рейтинг университетов работает в определённом понятийном пространстве, когда высшее образование понимается как некая коммерческая деятельность, в основе которой лежит бизнес-процесс обучения. При таком подходе к описанию этой деятельности применима терминология бизнеса: «конкуренция», «соперничество», «лидерство» и, как закономерный итог, «доход». С этой точки зрения некоторые возможности для анализа рейтинг всё-таки предоставляет. Особенно если анализ проводится с использованием данных не только самого рейтинга, но и иных, дополнительных (а иногда и основных), источников информации. Это необходимое условие для проведения исследования и получения достоверных результатов.

Выбор дополнительных информационных массивов зависит от цели исследования. Если в качестве цели поставить определение положения российской системы высшего образования в пространстве международных университетских рейтингов, или, иными словами, понять, каково место российской науки и образования на международном рынке, с какими странами мы можем реально конкурировать, тогда необходимо привлекать данные из информационных систем, в которых представлены результаты научно-исследовательской деятельности, например, из Web of Science Core Collection или Scopus. На основе данных Web of Science Core Collection развивается аналитическая система InCites, которая до самого последнего времени, точнее, до ноября 2014 г. служила основным источником данных для глобального рейтинга университетов Times Higher Education World University Rankings и других отраслевых и региональных рейтингов еженедельника Times Higher Education. Данные из этой аналитической системы были использованы для нашего исследования.

Что измеряют и что показывают международные рейтинги университетов

По сути, любой университет реализует всего две основные функции:

· образование — производство специалистов для различных отраслей народного хозяйства страны;

· науку — производство научного знания.

Все прочие виды деятельности университета, например, финансовая, международное и национальное сотрудничество, трансфер знаний, являются производными по отношению к указанным первичным функциям. Оценить уровень развития основных функций можно либо качественным путём, интерпретируя данные экспертных опросов, либо через количественные показатели. Первый метод получения данных для оценки — качественный — всегда необходимо очищать от излишков субъективности респондентов, будь они академиками или членами Royal Society. Количественные методы позволяют получать более объективную информацию, не зависящую от мнения опрашиваемых, но напрямую связанную с квалификацией специалистов, их использующих — чтобы что-то измерять, надо уметь пользоваться мерилом. Важное примечание: в России со времён СССР в вузах традиционно были развиты именно образовательные функции, а не научные. Фундаментальной наукой в СССР занимались государственные академии, прикладная наука развивалась в основном в многочисленных отраслевых подведомственных НИИ и в некоторой степени была представлена в отраслевых, как правило технических, вузах. Фактически всего три организации: МГУ, МФТИ и Новосибирский университет (отчасти и ЛГУ-СПбГУ) — развивались как исследовательские университеты. Все остальные вузы до второй половины 2000-х гг. занимались в основном образовательной деятельностью.

Все мировые рейтинги университетов: Academic Ranking of World Universities (далее — ARWU), QS World University Rankings (далее — QS WUR) и Times Higher Education World University Rankings (далее — THE WUR) — используют комбинированные методики, сочетающие качественные и количественные измерения образовательной и научной деятельности организаций. Но при этом значительно различаются соотношения методов оценки — количественные или качественные — в приложении к конкретным аспектам (вторичным функциям) научной или образовательной деятельности.

Так, методология оценки университетов в рейтинге ARWU представлена следующими индикаторами, измеряемыми количественными показателями.

1. Образовательная деятельность (12%):

· наличие нобелевских лауреатов / медалистов Филдса среди выпускников (10%);

· подушевая академическая деятельность университета в области образования (в расчёте на одного академического сотрудника) (2%).

2. Научная деятельность (88%):

· наличие нобелевских лауреатов / медалистов Филдса среди академического персонала (20%);

· высокоцитируемые исследователи среди академического персонала (20%);

· число публикаций (статей) в журналах Science и Nature (20%);

· число публикаций (статей) в изданиях, индексируемых в Science Citation Index Expanded and Social Science Citation Index (20%);

· академическая деятельность университета в области науки в расчёте на одного академического сотрудника (8%).

Львиная доля всей оценочной массы приходится в ARWU на индикаторы, связанные с оценкой научной деятельности, из 88% 44% — это показатели публикационной активности университета. Этот рейтинг, несомненно, может достойно оценить исследовательские университеты мирового уровня. Все прочие типы вузов, включая предпринимательские или нацеленные на педагогическую деятельность, обречены не попасть в ARWU. Российских университетов в этом рейтинге два: МГУ (84-е место) и СПбГУ (301–400-е места).

В рейтинге QS WUR методика оценки строится на иных количественных и качественных индикаторах, этот рейтинг — полная противоположность ARWU.

1. Образовательная деятельность (80%):

· репутация образования в университете: опросы экспертов (40%);

· соотношение академического персонала и студентов (20%);

· репутация образования в университете по опросам работодателей (10%);

· доля зарубежных студентов (5%);

· доля зарубежных сотрудников среди академического персонала (5%).

2. Научная деятельность (20%) — средняя подушевая цитируемость публикаций на одного сотрудника академического персонала.

Методика оценки в QS WUR претендует на универсализм с приоритетом именно образовательной функции и «недооценкой» науки в университете. В целом при 50% всей оценки, которая приходится на мнение экспертов и работодателей, можно говорить о том, что в QS WUR оценивается уровень маркетинга и рекламы университета, т.е. насколько хорошо вуз знают вне его стен. Если вуз не занимается активной PR-деятельностью, то его позиция в рейтинге, скорее всего, будет низкой. Но если вуз активно работает над своим имиджем, он появится в рейтинге даже при невысоком уровне образования или исследовательской активности. Всего в рейтинге QS WUR TOP-701+, который насчитывает более 800 организаций, представлен 21 российский университет, включая МГУ (114-я позиция) и 12 университетов из Проекта повышения конкурентоспособности 5–100 (не вошли питерский ИТМО и самарский СГАУ).

Рейтинг THE WUR, пожалуй, можно считать наиболее сбалансированным по соотношению как количественных и качественных методов оценки, так и науки и образования.

1. Образовательная деятельность (35%):

· репутация образования в университете: опросы экспертов (15%);

· доля сотрудников со степенью доктора наук среди академического персонала (6%);

· соотношение академического персонала и студентов (4,5%);

· соотношение студентов на программах докторантуры и бакалавриата (2,25%);

· доля зарубежных студентов (2,5%);

· доля зарубежных сотрудников среди академического персонала (2,5%);

· подушевой доход академического персонала от образовательных услуг (2,25%).

2. Научная деятельность (65%):

· репутация научной деятельности в университете: опросы экспертов (18%);

· научное влияние (нормализованная цитируемость публикаций) университета (30%);

· подушевая научная производительность (число статей на сотрудника академического персонала) (6%);

· доля журнальных публикаций с международным участием в общем публикационном массиве университета (2,5%);

· подушевой доход академического персонала от научных исследований и разработок (6%);

· подушевой доход академического персонала от коммерциализации разработок и трансфера знаний в корпоративный сектор (2,5%).

Рейтинг THE WUR, несомненно, претендует на объективную и полную оценку университета мирового уровня с хорошо развитой наукой, активной предпринимательской деятельностью и высококлассным образованием. Всё замечательно, только «верблюд не пролезает сквозь игольное ушко»: российские университеты не попадают в таблицу мировой лиги THE WUR. Точнее, попадает не более двух университетов в каждой редакции рейтинга TOП-400. Сейчас это МГУ (196-е место) и НГУ (301–350-е места).

«Правильный» рейтинг и его преимущества

Российские вузы не в состоянии занять достойные позиции среди университетов мирового класса не только в зоне TOП-100 (84-я позиция МГУ в ARWU — исключительное явление), но даже в сегменте TOП-400, где в QS WUR у России оказываются всего пять университетов, а остальные 16 расположились на скромных позициях ниже 400-й. В чём причина рейтинговых неудач отечественных университетов? Ведущие российские университеты развиваются по смешанной модели с преобладанием предпринимательского компонента. Исследовательская деятельность отечественных университетов пока скрыта от мирового академического сообщества, плохо развита публикационная активность, отечественные авторы ещё только начинают штурмовать редакции высокорейтинговых журналов и с трудом выдерживают конкуренцию со стороны зарубежных коллег из Европы и Северной Америки. Отсутствие внятной национальной научно-образовательной политики и, как следствие, устойчивого и значительного финансирования со стороны государства также не способствует развитию вузов до международного уровня. Отечественные вузы плохо вписываются в методики оценки мировых рейтингов: не та модель. Кроме того, наши университеты не конкурентоспособны по сравнению с исследовательскими университетами из США, Западной Европы, Канады, Китая, других развитых стран Азиатско-Тихоокеанского региона. Подобное надо сравнивать с подобным, для оптимального сопоставления компанию российским вузам должны составлять страны с сопоставимым уровнем развития экономики и национальной системы высшего образования.

Такая компания подобралась в рейтинге университетов стран BRICS и стран с развивающейся экономикой (THE BRICS & Emerging Economies Rankings), первый выпуск которого был опубликован в конце 2013 г. В начале декабря 2014 г. Фил Бейти (Phil Baty), шеф-редактор рейтинга THE WUR, привёз в Россию последнюю версию рейтинга (далее — BRICS EER 2015). Методика BRICS EER настроена на измерение достижений университетов из стран, которые в течение ближайшего десятилетия станут мировыми экономическими лидерами. В этих странах, как правило, активно распространяется предпринимательская модель вузов, часть которых далее развивает исследовательские компоненты. В целом такая гибридная модель достаточно близка к образцу, по которому развиваются российские университеты-лидеры. В методике BRICS EER внесён ряд существенных изменений по сравнению с базовой методикой, которая лежит в основе основного рейтинга THE WUR:

· увеличена до 10% суммарная оценка уровня интернационализации университета: доля зарубежных студентов, доля зарубежных сотрудников среди академического персонала и доля журнальных публикаций с международным участием;

· также увеличена до 10% оценка подушевого дохода академического персонала от коммерциализации разработок и трансфера знаний в корпоративный сектор;

· сокращён с 30 до 20% показатель научного влияния (нормализованная цитируемость публикаций).

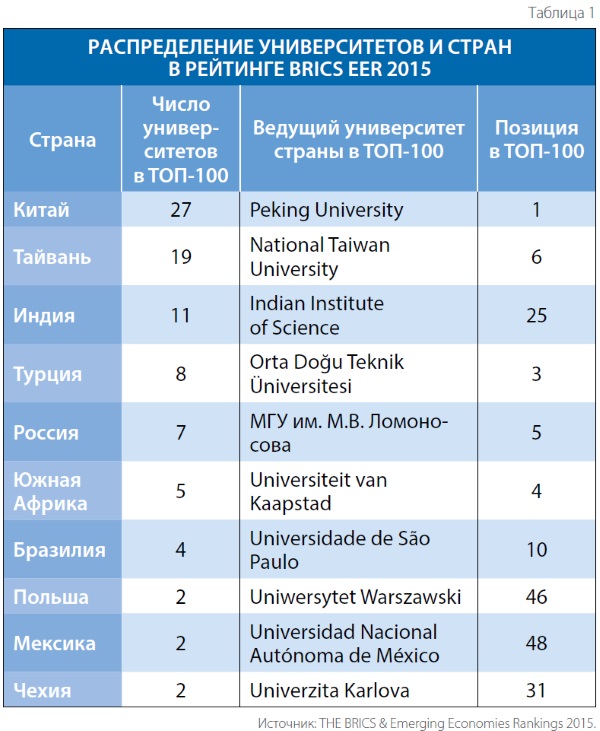

Доля суммарной оценки по образовательной деятельности составляет в BRICS EER 36,66%, доля общей оценки научных показателей соответственно 63,37%. Изменения, на первый взгляд, незначительные. Однако изменение внутри научного сегмента оценки — увеличение доли дохода от инновационной деятельности в пересчёте на сотрудника академического персонала и одновременное сокращение оценки по показателю научного влияния — благотворно сказалось на представительстве университетов России и некоторых других стран с сопоставимыми агрегированными показателями в рейтинге BRICS EER 2015 (табл. 1).

Публикационная активность ведущих стран из рейтинга BRICS EER 2015

Итак, семь университетов России вошли в первую сотню пусть ведущего, но пока ещё регионального рейтинга вузов. Это нормальный результат или нас опять недооценили? Насколько обосновано соседство России с такими странами, как Турция, Тайвань, Индия, Южная Африка, Бразилия? Таблица 1, действительно, вызывает подобные вопросы. Но данные этой таблицы могут быть обоснованы и подтверждены другими источниками, в частности библиометрическими данными из аналитической системы InCites. Поскольку на библиометрию в рейтинге BRICS EER приходится в совокупности почти 30% всей оценки, было бы логично проверить именно по показателям научных достижений достоверность и обоснованность местоположения России среди стран с активно развивающимися экономикой, наукой и образованием, а не среди США или Западной Европы.

Для сравнительного анализа использовались следующие метрики, характеризующие публикационную деятельность изучаемых стран.

Число опубликованных работ за 10-летний период (с 2005 по 2014 гг. включительно). Индикатор характеризует общую научную производительность (рис. 1).

Нормализованная цитируемость журнальных публикаций страны с 2009 по 2013 гг. Это комплексный качественный показатель научной результативности. Он рассчитывается как средняя цитируемость журнальных публикаций страны, нормированная по отношению к средней цитируемости журнальных публикаций по миру (рис. 2).

Доля процитированных журнальных публикаций, вышедших с 2009 по 2013 гг. Этот показатель наглядно демонстрирует уровень значимости публикаций для профессионального сообщества, насколько сообществу интересны (или неинтересны) статьи тех или иных авторов, коллективов, стран (рис. 3).

На рис. 1 показано, как вяло, в среднем не более чем на 2% в год, увеличивается научная производительность России на фоне стремительно растущей активности Китая, Индии, Бразилии, Турции, Польши. Чуть медленнее возрастает число публикаций Тайваня, Мексики, Чехии, Южной Африки. Отметим, что к российскому уровню производительности вплотную подошла Турция, опубликовавшая практически одинаковое с Россией число работ в 2014 г.

Рост публикационной активности сопровождается повышением качества опубликованных работ. Пока ещё в кластере стран с развивающейся экономикой выше среднемирового показателя работают исследователи только из Чехии и Южной Африки. К мировому уровню поднимается и нормализованная цитируемость китайских публикаций, а также научных работ Тайваня. Российские же статьи цитируются в среднем почти в два раза ниже среднемирового уровня. По этому показателю мы уступаем всем странам, даже Турции, Бразилии, Индии.

Рисунок 3 подтверждает тезис о плохой цитируемости отечественных публикаций: только половина из работ, опубликованных за период с 2009 по 2013 гг. с участием российских авторов, была процитирована. В то же самое время те, кто публикует качественные статьи, хорошо цитируются. До 2/3 всего объёма опубликованных трудов процитировано в Тайване и Чехии, близки к этому показателю Южная Африка и Китай. И только Турция и Бразилия находятся на сопоставимом с Россией уровне, хотя и опережают её.

Вместо заключения

Сравнительный анализ публикационной активности, проведённый для стран — лидеров рейтинга BRICS EER, показывает, что российская система высшего образования пока ещё конкурентоспособна по сравнению со странами, где интенсивно развиваются экономика, наука и образование. Страны BRICS вкупе с аналогичными государствами являются для России странами-референтами, по крайней мере, в области высшего образования и науки. При этом Россия отстала от Китая, увеличивается разрыв с Индией и Бразилией. Реальными конкурентами становятся Турция и Тайвань, ежегодные темпы научного роста которых на 15–20% выше российских.

Российские университеты адекватно оцениваются в региональном рейтинге BRICS EER 2015. Учитывая интенсивное и стабильное развитие экономики Китая, Индии, Бразилии, можно предположить, что уже к 2020 г. эти страны прочно войдут в первую десятку наиболее развитых стран мира, при этом Китай станет лидером не только экономическим. Можно ожидать, что рейтинг BRICS EER вырастет из регионального и станет более значимым.

Большинство российских университетов не соответствует параметрам англосаксонской академической модели «исследовательский университет мирового уровня», они другие по сути. Поэтому продвигаться в мировых университетских рейтингах, ориентированных на методику оценки по параметрам этой модели, отечественным вузам необычайно сложно. Можно изменить четыре-пять университетов, которые попадут в редакции TOP-200, даже TOП-100, но систему такая единичная трансформация не изменит. Наша модель развития пока что близка к Турции, Индии, Бразилии, Южной Африке. Это, собственно, и показывают рейтинги.

ИСПОЛЬЗУЕМАЯЛИТЕРАТУРА

1. World University Rankings 2014 // Academic Ranking of World Universities. ShanghaiRanking Consultancy, 2015. — URL: www.shanghairanking.com/ . — 13.03.2015.

2. World University Rankings 2014-2015 methodology // Times Higher Education: World University Rankings. TES Global, 2014. — URL: www.timeshighereducation.co.uk/world-university-rankings/2014-15/world-ranking/methodology. — 15.03.2015.

3. QS World University Rankings: Methodology // Top Universities: University Rankings, Guides, Forums & Events. QS Quacquarelli Symonds, 2014. — URL: www.topuniversities.com/university-rankings-articles/world-universityrankings/qs-world-university-rankings-methodology. — 13.03.2015.

BRICS & Emerging Economies Rankings 2015 // Times Higher Education, 2015. — URL: www.timeshighereducation.co.uk/world-universityrankings/2015/brics-and-emerging-economies . — 13.03.2015.

4. Web of Science (v.5.16.1) — Web of Science Core Collection. — Thomson Reuters, 2015. — URL: www.isiknowledge.com/ . — 15.03.2015.

5. InCites. — Report Created: 28.01.2015. — Data Processed: 01.10.2014. — Data Source: Web of Science — Web of Science Core Collection. — Thomson Reuters, 2014. — URL: www.isiknowledge.com/incites. — 28.01.2015.

Автор Павел Геннадьевич АРЕФЬЕВ, главный специалист Национального фонда подготовки кадров

Рубрика: Наука и образование

Год: 2015

Месяц: Апрель

Теги: Павел Арефьев